KETI

2020.08 ~ 2020.12

교통사고 탐지

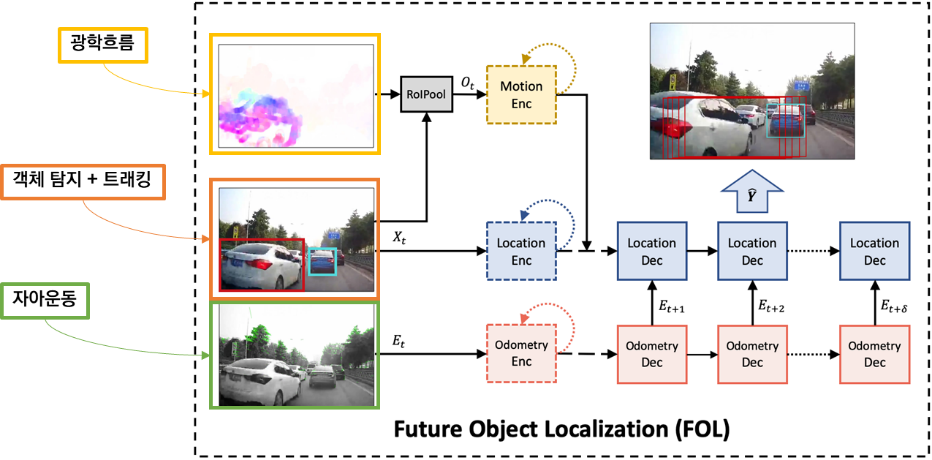

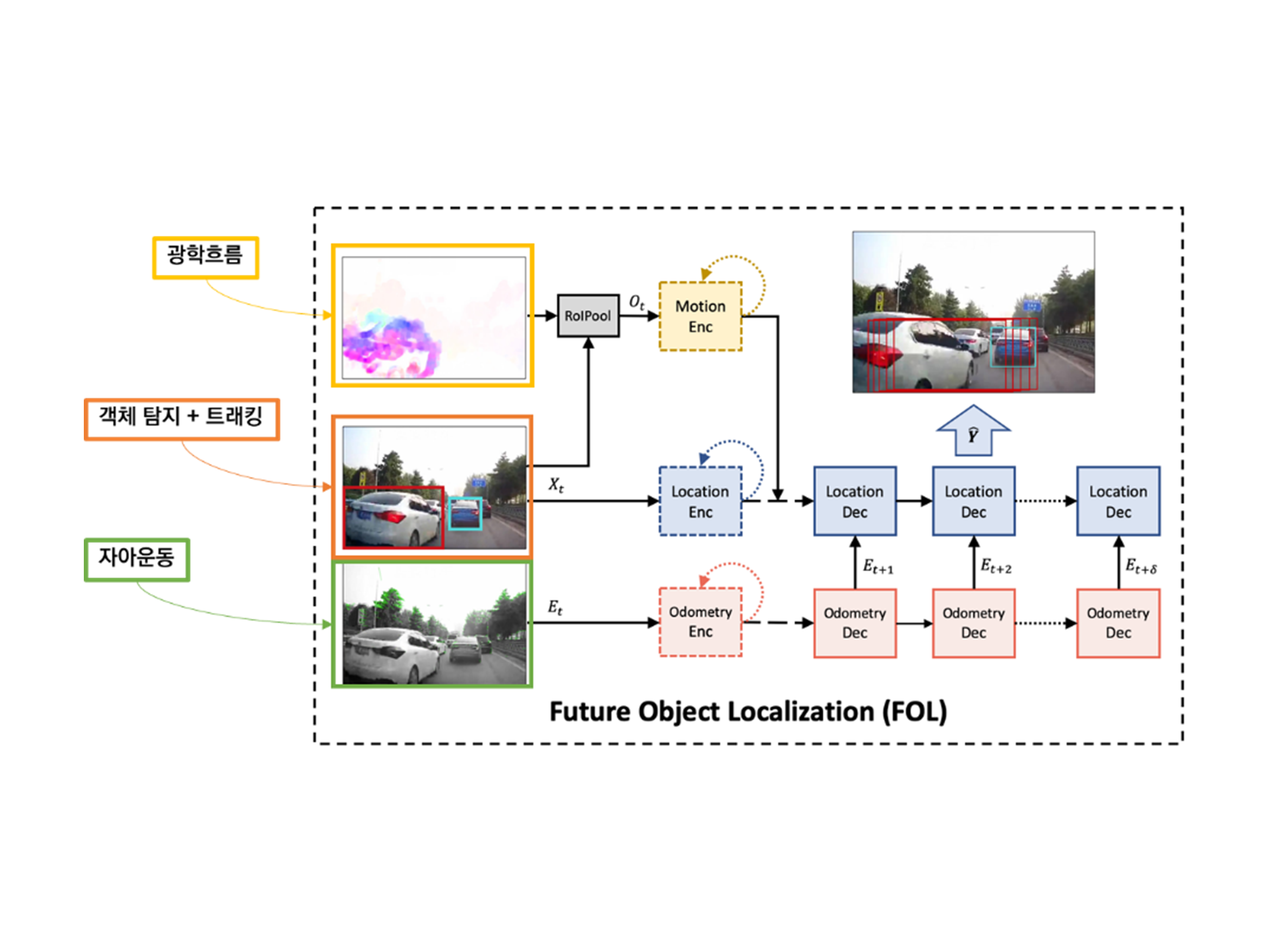

Python, keras, pytorch, Yolov4, DeepSort, FlowNet2.0, ORBSLAM2

Traffic Accident Detection

Connected Vehicles (CV) Traffic Accident Detection

Traffic Accident Detection

Connected Vehicles (CV) Traffic Accident Detection

KETI

2020.08 ~ 2020.12

교통사고 탐지

Python, keras, pytorch, Yolov4, DeepSort, FlowNet2.0, ORBSLAM2

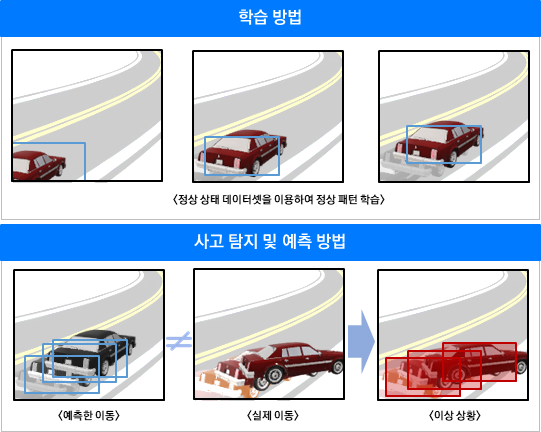

Description

본 프로젝트는 전자기술연구원(KETI)에서 진행되는 프로젝트로 데이터 및 코드는 대외비 입니다.

데이터, 코드를 제외한 프로젝트 과제 내용만 공유합니다.